接触过seo小伙伴一定知道robots具体意义,但也有一些合作伙伴刚刚开始学习网站robots到底是什么意思还是一头雾水。所以,网站robots到底是什么?它有什么用?本文将向您介绍网站robots具体意义,其用途、制作技巧、规律及相关注意事项。

如何设置robots?网站robots.txt设置教程

一、网站robots含义和操作模式

网站robots位于域名根目录的网站中的系统文件robots主要功能是在网络上捕获和索引内容,然后提供给信息搜索者。当我们搜索我们想要的内容时,搜索引擎会从一个网站获得链接,以便快速捕获网站。

最终会获得大量相关网站的链接,通常被称为蜘蛛爬行robots它将帮助我们掌握网络中的相关内容,即引导和控制蜘蛛爬行规则。

二、网站robots的主要作用

首先,如果网站不愿意公开相关内容,可以禁止蜘蛛爬行,以便充分准备相关内容。

其次,蜘蛛可以禁止搜索一些对用户毫无意义的系统文件,如无关的应用程序、脚本和其他无关的代码,这可以节省我们的搜索时间。此外,它还可以有效地避免搜索引擎获得一些网站复制或重复的内容,最重要的是它可以阻止一些恶意的蜘蛛。

如果我们可能会不小心让一些搜索引擎抓住我们整个网站的内容,这可能很危险,但如果我们使用这个网站robots,它不仅更安全,而且非常方便。

三、做好网站robots一些方法、技能和规律

首先,我们需要强调网站robots文件的格式是.txt不能做其他格式的格式robots文件。robots所有文件的字母都必须以小写的形式存储在网站的根目录中。

另外,制作网站robots时,User-agent、Allow、Disallow、Sitemap这些单词的第一个字母必须大写,后面的字母需要小写格式。最重要的是-:背面的空格必须是英文输入状态下的空格。

User-agent:*——这里的“*它是一个通配符,代表所有搜索引擎的类型。

Disallow:/require/-定义为禁止蜘蛛搜索require目录下的内容。

Disallow:.jpg$——所定义的是禁止蜘蛛搜索网页中的所有内容jpg格式的照片。

Allow:.gif$——所定义的是允许蜘蛛搜索网页中的一切gif动态图片的格式。

四、网站做得不好robots的弊端

若做得不好robots文件很可能会浪费服务器资源,获取一些不必要或毫无意义的捕获内容。如果情况严重,也会泄露客户信息中的私人信息,给网站或公司带来很多损失。

五、网站robots文件受到限制怎么办?

首先,我们需要把设置网站允许存在robots文件,改变robots限制语法,解除蜘蛛访问限制,然后到网站管理员的背景robots测试和更新文件。网站管理员的背景经常告诉我们抓取失败,此时不要担心,我们抓取几次会触发蜘蛛抓取网站行动。

然后我们申请增加蜘蛛抓取的频率。此外,我们还应该告诉网站反馈中心,这种情况是由不当操作引起的,而不是恶意操作。经过一系列步骤,我们耐心地等待蜘蛛。

网站robots文件的检测

百度搜索“robots检测 爱站”(https://tools.aizhan.com/robots/),如下图1-1所示,下图1-1所示。

如何设置robots?网站robots.txt设置教程

图1-1:robots文件检测

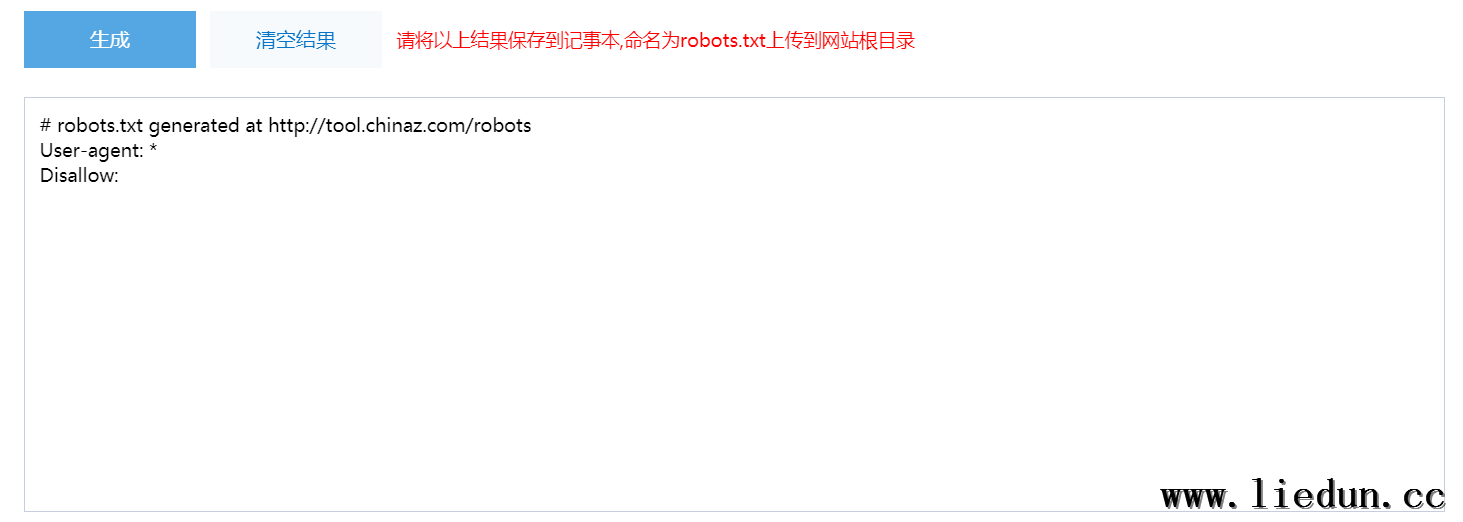

网站robots文件的生成

百度搜索“robots文件生成”(http://tool.chinaz.com/robots/),可以根据可视化选项生成robots复制内容.txt如图1-2所示,图1-3所示。

图1-2:可视化robots选项

图1-3:生成robots内容

网站robots与收录的关系

robots该文件直接定义了网站允许和禁止访问的蜘蛛和页面。如果蜘蛛被禁止,搜索引擎将不包括网站的任何内容。如果蜘蛛允许爬行某些目录或页面,蜘蛛可能会爬行,但不一定能保证包含,因为这也与文章的内容质量等因素有关。

所以,robots文件会影响收录,但不代表有robots文件一定会让你的网站有很好的收录效果和排名。以上是网站robots希望你能从文件介绍中获益。